لیست مطالب

امروزه، هوش مصنوعی (AI) به ستون اصلی تحولات دیجیتال تبدیل شده است. از الگوریتم های پیچیده یادگیری عمیق گرفته تا مدلهای زبانی بزرگ (LLMs)، همه به منابع پردازشی عظیمی نیاز دارند. با این حال، بسیاری از کاربردهای واقعی هوش مصنوعی شامل وظایفی هستند که به منابع کمتری نیاز دارند و ماهیت اجرایی رویداد محور (Event-Driven) دارند؛ اینجاست که معماری بدون سرور (Serverless) وارد عمل می شود و انقلابی در نحوه ارایه خدمات هوش مصنوعی، به خصوص برای بارهای سبک (Light Workloads) ایجاد می کند.

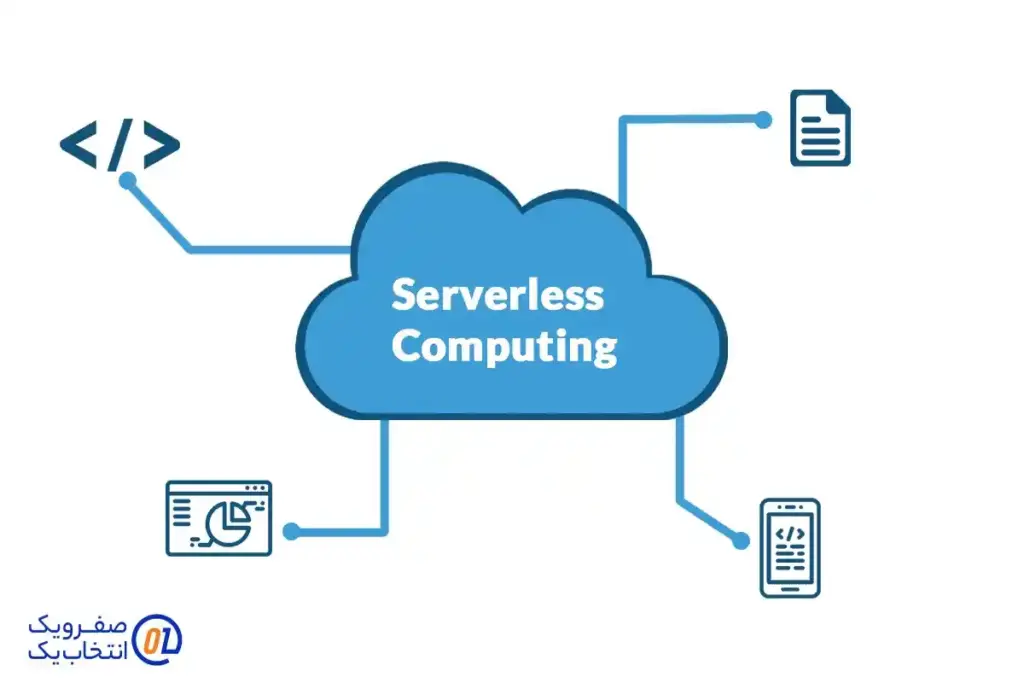

Serverless چیست؟

Serverless یک مدل توسعه برنامه های ابری است که در آن، فراهم کننده خدمات ابری (Cloud Provider) تمامی مسولیت های مربوط به مدیریت زیرساخت سرور (شامل تامین، نگهداری، مقیاس دهی و نگهداری سیستم عامل) را بر عهده می گیرد. توسعه دهنده فقط بر روی کد منطق کسب و کار تمرکز می کند و دیگر نگران این نیست که سرور او کجا، چگونه یا در چه ظرفیتی اجرا می شود.

مدل اصلی Serverless بر پایه توابع به عنوان سرویس (Function as a Service – FaaS) استوار است. یعنی کد شما به صورت یک تابع کوچک و مستقل نوشته می شود و تنها در پاسخ به یک رویداد خاص (مانند بارگذاری یک فایل، ثبت یک کاربر جدید یا دریافت یک پیام) اجرا می شود. پس از پایان اجرا، تابع فورا غیر فعال می شود و هیچ هزینه ای برای زمان بیکاری سرور پرداخت نمی کنید.

تفاوت بنیادین با روشهای سنتی

| ویژگی | مدل سنتی (سرور اختصاصی/مجازی) | معماری Serverless (بدون سرور) |

| مدیریت سرور | به طور کامل بر عهده کاربر است. | به طور کامل بر عهده فراهم کننده ابری است. |

| مقیاس پذیری | نیاز به تنظیم دستی و هزینه اضافی (Provisioning) دارد. | به صورت خودکار و در لحظه انجام می شود. |

| هزینه | پرداخت ثابت بر اساس مدت زمان روشن بودن سرور. | پرداخت در ازای مصرف واقعی (زمانی که کد در حال اجراست). |

| استفاده از منابع | منابع حتی در زمان بیکاری سرور نیز اشغال هستند. | منابع فقط در هنگام اجرای تابع مصرف می شوند. |

بارهای سبک AI: وقتی هوش مصنوعی به منابع عظیم نیاز ندارد

وقتی به هوش مصنوعی فکر می کنیم، اغلب ذهن ما به سمت مدلهای سنگین آموزش داده شده با میلیاردها پارامتر می رود. اما بسیاری از عملیاتهای روزمره هوش مصنوعی وظایفی هستند که نیاز به محاسبات سنگین و دایمی ندارند. این وظایف، همان بارهای سبک AI هستند.

بارهای سبک AI معمولا در مرحله استنتاج (Inference) اجرا می شوند و نه در مرحله آموزش (Training). مرحله استنتاج زمانی است که مدل AI قبلا آموزش دیده و اکنون برای پیش بینی یا تصمیم گیری بر روی داده های ورودی جدید استفاده می شود.

نمونه هایی از بارهای سبک AI:

- تحلیل احساسات بلادرنگ (Real-Time Sentiment Analysis): یک مدل کوچک طبقه بندی کننده برای تجزیه و تحلیل یک کامنت کوتاه وب سایت یا یک توییت به محض ارسال. این عملیات در حد میلی ثانیه انجام می شود.

- بازسازی اندازه تصویر (Image Resizing) یا فشرده سازی ساده: استفاده از یک تابع AI برای تشخیص کیفیت یا ابعاد یک تصویر پس از بارگذاری توسط کاربر و انجام تنظیمات لازم.

- وظایف طبقه بندی داده (Data Classification): مرتب سازی یک جریان داده ورودی به گروه های از پیش تعریف شده (مثلا ایمیلهای دریافتی را به پوشه های "تبلیغاتی"، "مهم" و "عادی" تفکیک کند).

- پردازش زبان طبیعی (NLP) ساده: اجرای یک مدل سبک برای استخراج نهادهای نامگذاری شده (Named Entity Recognition) از یک پاراگراف کوتاه.

- چت باتهای ساده و پاسخ دهی به سوالات متداول: استفاده از مدلهای کم حجم برای پاسخگویی به سوالات اولیه مشتریان.

در تمام این موارد، تابع هوش مصنوعی تنها برای چند ثانیه یا حتی چند صد میلی ثانیه اجرا می شود و سپس خاموش می شود. نگهداری یک سرور اختصاصی گران قیمت برای انجام این کارها به صورت متناوب، اتلاف منابع است.

مزایای Serverless برای اکوسیستم AI

تلفیق معماری Serverless با بارهای سبک هوش مصنوعی، مزایای اقتصادی و عملیاتی قابل توجهی به همراه دارد:

۱. صرفه جویی شدید در هزینه با مدل پرداخت در ازای مصرف

بزرگ ترین مزیت Serverless، مدل مالی آن است: پرداخت فقط در ازای اجرا. بر خلاف سرورهای مجازی (VPS) یا سرورهای اختصاصی که به صورت ماهانه اجاره می شوند، در Serverless شما تنها برای تعداد دفعات اجرای تابع و مدت زمان دقیق پردازشی که صرف می کند، هزینه می دهید.

برای وظایف هوش مصنوعی که ممکن است در طول روز فقط چند بار یا به صورت خوشه ای (Burst) اجرا شوند، این مدل می تواند هزینه ها را تا ۹۰ درصد کاهش دهد. برای مثال، یک سرویس تحلیل احساسات که فقط هنگام دریافت کامنت فعال می شود، فقط همان چند ثانیه را هزینه بر می دارد، در حالی که سرور سنتی، کل ۲۴ ساعت را باید هزینه کند.

. مقیاس پذیری بی وقفه و خودکار

ماهیت Serverless در پاسخ به رویدادها است. اگر وب سایت شما ناگهان با هزاران بارگذاری تصویر در ثانیه مواجه شود (که هر کدام نیاز به پردازش AI دارند)، پلتفرم Serverless به صورت خودکار و فوری هزاران نمونه موازی از تابع AI شما را برای مدیریت این حجم کاری ایجاد می کند.

این قابلیت مقیاس پذیری خودکار تضمین می کند که عملکرد سرویس شما تحت هیچ فشار ترافیکی دچار افت نشود. به محض این که اوج ترافیک بگذرد، نمونه ها به همان سرعت خاموش می شوند. این امر به ویژه برای وب سایتها و پلتفرمهای پر ترافیک که ممکن است اوج مصرف غیر منتظره داشته باشند، حیاتی است.

۳. کاهش سربار عملیاتی (NoOps)

با Serverless، دیگر نیازی به تیمی بزرگ از مهندسان DevOps برای مدیریت زیرساخت نیست. توسعه دهندگان از نگهداری سرورها، به روزرسانی سیستم عامل، مدیریت پچ های امنیتی و پیکربندی شبکه رها می شوند.

این تمرکز بر روی کد نویسی و منطق هوش مصنوعی به جای زیرساخت، به تیمها اجازه می دهد تا با سرعت بیشتری ویژگی های جدید را ارایه دهند و به چابکی (Agility) بالاتری در توسعه دست یابند. این رویکرد، در واقع مفهوم عملیات صفر (NoOps) را در فضای هوش مصنوعی عملی می کند.

Serverless در عمل

معماری بدون سرور برای انواع پایپ لاین های داده و هوش مصنوعی که ماهیت متغیر دارند، عالی است:

۱. پردازش محتوای تولید شده توسط کاربر (UGC)

وقتی کاربران عکس، ویدیو یا متن آپلود می کنند، می توان از توابع Serverless برای پردازش سریع آنها استفاده کرد:

- تشخیص محتوای نامناسب: یک تابع Serverless بلافاصله پس از بارگذاری تصویر فعال می شود و یک مدل سبک AI برای فیلتر یا نشانه گذاری محتوای ممنوعه اجرا می کند.

- خلاصه سازی و برچسب گذاری (Tagging): پس از آپلود یک سند متنی، یک تابع AI می تواند به سرعت آن را بخواند، خلاصه کند و برچسبهای متناسب (Tags) به آن اختصاص دهد.

۲. چت بات ها و سیستمهای تعاملی

توابع Serverless برای مدیریت منطق پشت چت باتها بسیار مناسب هستند. هر پیام ورودی کاربر به عنوان یک رویداد تلقی می شود:

- پیام دریافت می شود (رویداد).

- تابع Serverless فعال می شود.

- مدل AI سبک، قصد (Intent) کاربر را تشخیص می دهد.

- پاسخ مناسب ارایه شده و تابع غیر فعال می شود.

این مدل تضمین می کند که چت بات در اوج مصرف می تواند میلیونها کاربر را به طور همزمان مدیریت کند و در زمان بیکاری، هزینه ای ایجاد نمی کند.

۳. سیستم های پایش و هشداردهی هوشمند

Serverless می تواند برای پایش مداوم داده ها از حسگرها (IoT) یا لاگهای سرور استفاده شود:

- داده های حسگرها وارد یک جریان داده می شوند (رویداد).

- تابع Serverless فعال می شود.

- یک مدل تشخیص ناهنجاری (Anomaly Detection) سبک، داده ها را برای یافتن رفتارهای غیر معمول بررسی می کند.

- در صورت تشخیص ناهنجاری، یک هشدار ارسال می شود (رویداد خروجی).

چالشها و ملاحظات هنگام استفاده از Serverless برای AI

اگرچه Serverless مزایای بسیاری دارد، اما محدودیت هایی نیز وجود دارد که باید در نظر گرفته شوند:

۱. راه اندازی سرد (Cold Start)

راه اندازی سرد یک تاخیر اجباری در اجرای تابع Serverless است که زمانی رخ می دهد که تابع برای مدت طولانی غیر فعال بوده و پلتفرم باید محیط اجرای آن (شامل دانلود مدل AI و بارگذاری آن در حافظه) را از نو بسازد.

این تاخیر اولیه (که ممکن است چند ثانیه طول بکشد) می تواند برای برنامه هایی که نیاز به پاسخگویی فوری و بلادرنگ دارند، مشکل ساز باشد. راهکارهای مقابله با این مشکل شامل نگهداری فعال یک نمونه (Provisioned Concurrency) یا طراحی بهینه تابع با مدلهای کوچک تر است.

۲. محدودیت در زمان اجرا و حافظه

پلتفرمهای Serverless معمولا محدودیت های سختی را برای حداکثر زمان اجرای تابع (مثلا ۱۵ دقیقه) و میزان حافظه (RAM) قابل دسترسی تعیین می کنند. این محدودیتها به این معنی است که:

- آموزش مدلهای AI (Training) در Serverless تقریبا غیر ممکن است. برای این کارها باید از سرورهای اختصاصی یا سرورهای ابری با منابع ثابت و GPU استفاده کرد.

- استفاده از مدلهای AI بسیار بزرگ به دلیل محدودیت حافظه و اندازه پکیج (Package Size) می تواند چالش برانگیز باشد.

۳. وابستگی به فراهم کننده ابری (Vendor Lock-in)

هر فراهم کننده ابری (مانند AWS Lambda، Google Cloud Functions یا Azure Functions) دارای ابزارها، API ها و مدل قیمت گذاری خاص خود است. مهاجرت یک پایپ لاین Serverless هوش مصنوعی از یک پلتفرم به پلتفرم دیگر می تواند پیچیده و زمان بر باشد. با این حال، استفاده از چارچوب های توسعه متن باز مانند Serverless Framework می تواند این وابستگی را تا حدودی کاهش دهد.

نتیجه گیری

معماری بدون سرور برای بارهای AI سبک، یک تغییر دهنده بازی است. با انتخاب درست این معماری، شما می توانید از مزایای مقیاس پذیری بی نهایت و پرداخت دقیق در ازای مصرف بهره مند شوید و تمرکز خود را از دغدغه های زیرساخت به سمت نوآوری در حوزه هوش مصنوعی معطوف کنید. با نزدیک شدن به خدمات سرور ابری صفرویک، ما آماده ایم تا در این مسیر، بهترین راهکارهای ابری را برای تحقق ایده های هوش مصنوعی شما فراهم نماییم.

مجله صفرویک

مجله صفرویک